”relu sigmoid 函数 梯度 激活 激活函数“ 的搜索结果

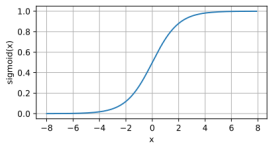

在实现多层感知机代码实现中使用了ReLU激活函数: ReLU(x)=max(x,0)ReLU(x)=max(x,0)ReLU(x)=max(x,0) 形状大概是这样的 这里根据几个问题来进行回答解释 为什么要使用激活函数呢? 简单来说激活函数的作用就是将...

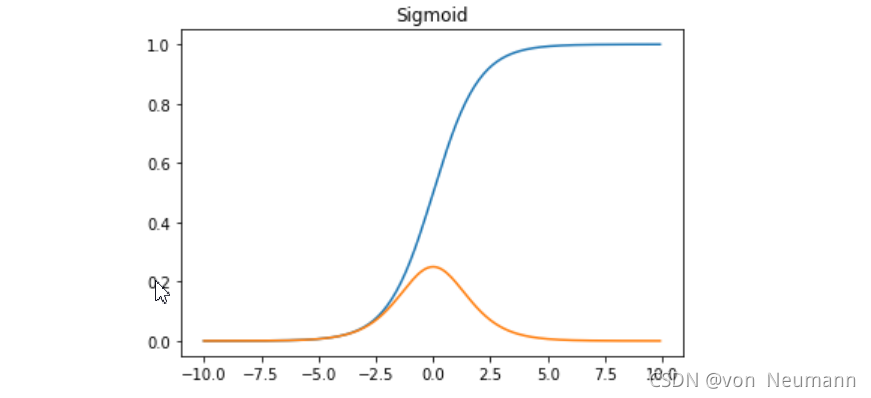

深度学习笔记(4)——Sigmoid和Relu...Relu是一个非常优秀的激活哈数,相比较于传统的Sigmoid函数,有三个作用: 1. 防止梯度弥散 2. 稀疏激活性 3. 加快计算 首先我们看下sigmoid和relu的曲线 然后可以得到sigm...

而且根据输入激活函数随机性的原理我们可以知道,经过这个激活函数处理,有一般的概率输出为0,由反向传播的原理知道,经过激活函数输出为0,那么这激活函数在这次样本输入中其梯度就为0,也就是不会被更新,且该...

什么是激活函数 激活函数(Activation functions)对于人工神经网络模型去学习、理解非常复杂和非线性的函数来说具有十分重要的作用。它们将非线性特性引入到我们的网络中。...Sigmoid激活函数 sig

1.为什么要使用激活函数 因为线性函数能拟合的模型太少,多层线性神经网络的...tanh几乎在所有情况下的表现都比sigmoid好,因为它的输出值介于-1到1,激活函数的平均值更接近于0,这样可以达到类似zero-centered(数

因此现在一般都不使用Sigmoid函数,而是使用ReLu激活函数。2. ReLu激活函数: ReLu激活函数:当x为负值之后y取0,x为正数之后,y随x的值得增大而增大,这样就可以解决梯度消失问题。现在一般都是用ReLu激...

激活函数给神经元引入了非线性因素,如果不用激活函数,神经网络每一层输出都是上层输入的线性函数,无论神经网络有多少层,输出都是输入的线性组合。 激活函数使得神经网络可以任意逼近任何非线性函数,这样神经...

数据流经过sigmoid后,会发生明显的衰减。 假设前面对w做一个比较大的变化,经过sigmoid...所以ML界寻找替代 sigmoid的激活函数,如relu。 relu函数在大于0的部分梯度为常数,relu函数在小于0时的导数为0 ,...

本文将带您深入了解sigmoid和ReLU的奥秘,从工作原理到实现细节,再到在深度学习中的应用。通过本文的探讨,您将掌握激活函数的精髓,为您的神经网络设计和开发提供有力支持。

本文在综述一些经典激活函数和注意力机制理论的基础上,解读了一种“注意力机制下的新型激活函数”,即“自适应参数化修正线性单元”(Adaptively ...我们首先回顾一些最为常见的激活函数,包括Sigmoid激活函数、Ta...

激活函数 Rectified Linear Unit(ReLU) - 用于隐层神经元输出 Sigmoid - 用于隐层神经元输出 Softmax - 用于多分类神经网络输出 Linear - 用于回归神经网络输出(或二分类问题 Softmax激活函数只用于多于一个...

激活函数具有的特性激活函数的类别饱和激活函数Sigmoid激活函数Tanh(双曲正切函数)激活函数Sigmoid、Tanh激活函数引发的常见问题解决非饱和激活函数ReLU激活函数Leaky ReLU等变种激活函数 为什么要使用激活函数? ...

随着研究的进展,有一些变体,如Leaky ReLU、Parametric ReLU、ELU等,旨在改进激活函数的性能。Sigmoid函数将输入映射到(0,1)之间的范围,常用于二分类问题。然而,Sigmoid函数在输入远离零时梯度接近零,可能...

**概述:**ReLU函数的计算是在卷积之后进行的,因此它与tanh函数和sigmoid函数一样,同属于非线性激活函数。ReLU函数的倒数在正数部分是恒等于1的,因此在深度网络中使用relu激活函数就不会导致梯度小时和爆炸的问题...

推动深度学习变得兴起的主要因素包括:数据规模、计算量及算法的创新。 当前大多数算法的创新都是为了提升运算能力,使运算速度更快,尤其对于复杂的神经网络...从图中可以看到,在sigmoid函数箭头所指区域,梯度会...

(1) 从计算的角度上, Sigmoid和Tanh激活函数均需要计算指数, 复杂度 高, 而ReLU只需要一个阈值即可得到激活值。 (2) ReLU的非饱和性可以有效地解决梯度消失的问题, 提供相对宽的激活 边界。 (3) ReLU的单侧...

ReLU:优于Sigmoid的激活函数 在进行机器学习时,第一个接触到的激活函数一定是Sigmoid函数。所谓激活函数,是一种将输出改变为非线性的使得模型功能性更强的应用手段。而Sigmoid函数作为新人面孔中出现最频繁的激活...

ReLU(Rectified Linear Unit)激活函数是深度学习中最常用的激活函数之一,它的数学表达式如下:在这里,(x) 是输入,(f(x)) 是输出。ReLU激活函数的使用非常简单,它将输入(x)的所有负值变为零,而保持正值不变。...

推荐文章

- clip预训练模型综述_clip模型-程序员宅基地

- 使用xshell上传文件到linux服务器上,复制文件_xcell 如何拷贝本地文件到服务器-程序员宅基地

- chromedriver与chrome版本对应及驱动下载_chromedriver最新下载地址-程序员宅基地

- ubuntu16.04+CUDA9.0+cudnn7.0+caffe+matlabR2014b_ubuntu+caffe+cuda9.2+matlab2017b-程序员宅基地

- 使用 GitHub Actions 云编译 OpenWrt_github云编译网站-程序员宅基地

- Three.js 后期处理-通过扫描线和失真模拟电视屏幕-FilmPass-相机分层渲染_shaderpass.js-程序员宅基地

- latex百分号符号怎么输入_latex %-程序员宅基地

- PLC与触摸屏通信_plc和触摸屏如何通信-程序员宅基地

- 使用 CI/CD 优化前端构建的五种策略-程序员宅基地

- Crank Storyboard Suite入门(一)_crank_storyboard_suite-v5.3.0-程序员宅基地